L’épisode en dit long sur la nouvelle rivalité entre Nvidia et AMD. Dimanche soir, Jensen Huang, le patron du premier, a pris de vitesse Lisa Su, la directrice générale du second, qui devait s’exprimer quelques heures plus tard en ouverture du grand salon informatique Computex, qui se tient cette semaine à Taïwan. Il a profité de l’occasion pour annoncer la future génération de cartes graphiques (GPU) dédiées à l’intelligence artificielle générative, alors même que la prochaine génération, présentée en mars, n’est même pas encore commercialisée. Et aussi pour promettre de doubler la cadence d’innovation, en sortant un nouveau modèle par an, au lieu de tous les deux ans. De quoi voler la vedette à sa concurrente, qui tente de percer sur ce gigantesque marché, pour l’instant largement dominé par le groupe de Santa Clara.

Forte demande – Pionnier de l’informatique accélérée, qui consiste à coupler un processeur (CPU) avec un GPU, Nvidia est en effet au cœur de l’essor de l’IA générative, alors que l’entraînement des modèles nécessite une gigantesque puissance de calcul. Depuis un an et demi, et les spectaculaires débuts de ChatGPT, l’intérêt pour ses puces dépasse largement ses capacités de production. Entre février et avril, son activité data center a ainsi généré un chiffre d’affaires de 22,6 milliards de dollars, soit six fois plus qu’il y a deux ans. Ses profits ont grimpé en flèche: 15,2 milliards, contre seulement 1,6 milliard début 2023. Fort du déséquilibre entre l’offre et la demande, Nvidia souhaite désormais favoriser la vente de serveurs complets, beaucoup plus onéreux. Et tente aussi de prendre pied sur le marché du cloud.

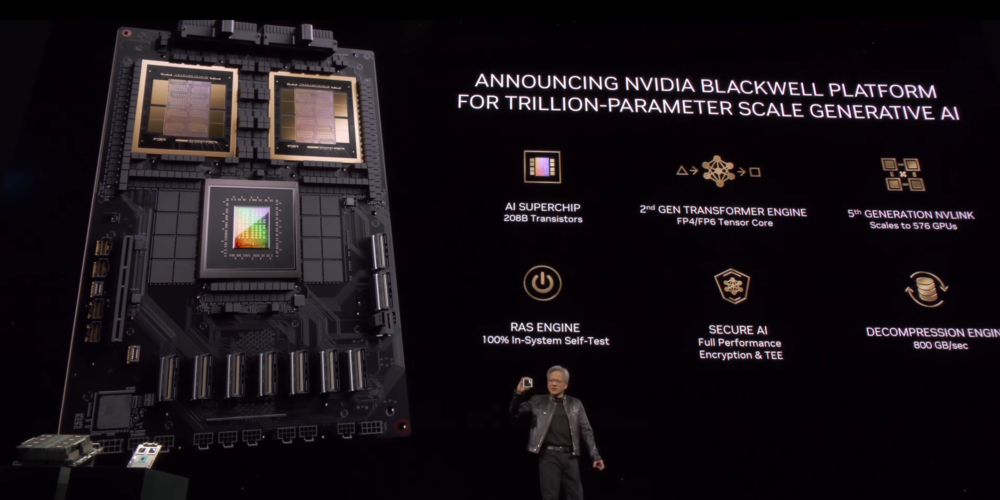

Besoins exponentiels – Dimanche, Jensen Huang a dévoilé la feuille de route de la société pour les trois prochaines années, avec le lancement en 2026 d’une nouvelle architecture de puces, baptisée Rubin en hommage à l’astronome américaine qui a prouvé l’existence de la matière noire. Avant cela, l’architecture Blackwell, qui va succéder en fin d’année à l’architecture Hopper, sur laquelle est bâti le GPU H100, la référence actuelle du secteur, aura le droit à une déclinaison “ultra”. La version “ultra” de Rubin sera, elle, commercialisée en 2027. Ce rythme effréné s’explique par les besoins croissants de puissance de calcul, à mesure que la taille des modèles augmente. “La quantité de données à traiter croît de manière exponentielle”, assure Jensen Huang, qui promet aussi des gains de temps et des économies d’énergie.

AMD toujours loin – Nvidia doit également préserver son avance technologique. Car sa réussite attire les convoitises. À sa poursuite, AMD est l’acteur le plus avancé. Fin 2023, le groupe, surtout spécialisé dans les CPU, a lancé son premier accélérateur dédié à l’IA. Il a même décroché un premier client d’envergure, avec Microsoft Azure. Mais AMD reste encore très loin de son concurrent: ses dirigeants espèrent en effet réaliser pour 4 milliards de dollars de vente sur l’ensemble de l’année. Lundi, Lisa Su a, elle aussi, promis de lancer un nouveau GPU par an. La prochaine génération sera commercialisée au quatrième trimestre. Elle affichera des performances supérieures au H200 de Nvidia, la puce actuelle la plus puissante de Nvidia. Mais elle sera nettement dépassée par le prochain B200, qui sera disponible d’ici là.

Pour aller plus loin:

– L’IA générative propulse Nvidia vers de nouveaux sommets

– Sam Altman cherche des milliards de dollars pour concurrencer Nvidia