Un chiffre d’affaires multiplié par trois au troisième trimestre de son exercice fiscal. Et des profits multipliés par 14, tout près de la barre symbolique des dix milliards de dollars. Nvidia n’en finit plus de surfer sur l’engouement autour de l’intelligence artificielle générative pour atteindre de nouveaux sommets – qui ont porté sa capitalisation boursière au-delà des 1.000 milliards. Le groupe de Santa Clara enregistre toujours une très forte demande pour ses cartes graphiques (GPU), considérées comme les plus performantes pour entraîner et faire tourner les derniers modèles d’IA. Et il compte désormais profiter de sa position de force pour viser de nouveaux horizons, à commencer par l’immense marché du cloud. Quitte à marcher sur les plates-bandes des grands acteurs du secteur, qui sont aussi… ses principaux clients.

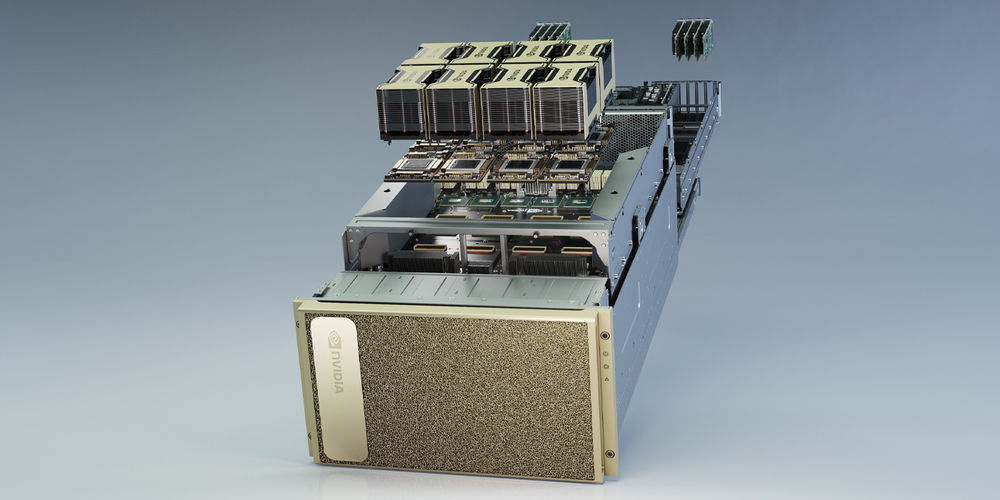

20.000 dollars par mois – Le cloud est l’autre grand gagnant de l’émergence de l’IA générative, car peu d’entreprises disposent de la puissance de calcul nécessaire. Baptisée DGX Cloud et officiellement lancée cet été, l’offre de Nvidia est particulière. Elle ne repose pas sur une infrastructure propre: elle est hébergée par d’autres plateformes cloud, celles de Microsoft, Google et Oracle. Le service donne accès à un ou plusieurs systèmes DGX, composés de 8 GPU dédiés à l’IA. Un système vendu entre 200.000 et 400.000 dollars, selon le modèle de GPU utilisé, “sans compter les coûts liés au stockage et au réseau”, précise Serge Palaric, un responsable de Nvidia en France. DGX Cloud est, lui, proposé à partir de 19.699 dollars par mois. Un prix qui a été divisé par deux par rapport au tarif de lancement “pour stimuler la demande”.

“AI factory” – Pour se démarquer des grandes plateformes de cloud, Nvidia met en avant un “écosystème complet de calcul”, comprenant des cartes graphiques, mais aussi des logiciels et des modèles d’intelligence artificielle générative . “C’est une AI factory dans laquelle toutes les briques possibles sont disponibles pour permettre à nos clients de développer leurs applications”, explique Serge Palaric. DGX Cloud permet ainsi d’accéder à des modèles open source, notamment Llama de Meta et Mistral de la start-up française éponyme. Et aussi à un catalogue de modèles pré-entraînés, conçus par Nvidia, permettant à des entreprises de bâtir des modèles personnalisés à partir de leurs propres données. Et ainsi de concevoir des robots conversationnels ou des assistants optimisés pour leur domaine d’activité.

Refus d’Amazon – Les ambitions du fabricant de GPU pourraient le transformer en rival des géants de cloud, réduits au rôle d’intermédiaires, laissant ainsi échapper une partie de la valeur. “Nous ne sommes pas concurrents, répond Serge Palaric. Nous fournissons un service différent”. Amazon Web Services n’a pas souhaité participer, estimant que le modèle économique “ne faisait pas sens”, d’après Reuters. Nvidia discute désormais avec ses partenaires pour qu’ils proposent directement son offre à leurs clients. Des négociations facilitées par l’importance de ses puces d’IA ? “C’est difficile de leur refuser quelque chose”, souffle un acteur du marché. Et même si Nvidia réfléchirait aussi à lancer ses propres data centers, selon The Information, ce qui le placerait en concurrence frontale avec AWS, Microsoft et Google.

Pour aller plus loin:

– Pourquoi Microsoft lance sa propre puce dédiée à l’IA

– L’autorité de la concurrence soupçonne Nvidia de pratiques anticoncurrentielles