Il y a cinq ans, ils n’étaient que 9.000 à assister à la GTC. Cette année, plus de 300.000 personnes doivent participer, en présentiel ou en ligne, à cet évènement organisé par Nvidia, qui se tient jusqu’à jeudi à San José, en Californie. Ce qui n’était alors qu’une conférence destinée à quelques milliers de développeurs très spécialisés est devenu le “Woodstock de l’intelligence artificielle”, selon l’expression popularisée par un analyste de Bank of America. Autrement dit, un rendez-vous incontournable pour l’ensemble du secteur technologique. Et le symbole de l’importance prise par le fabricant américain de cartes graphiques (GPU) dans l’essor de l’IA générative. Lundi, la présentation d’ouverture de Jensen Huang, son charismatique patron, était ainsi autant attendue, si ce n’est plus, qu’une keynote d’Apple.

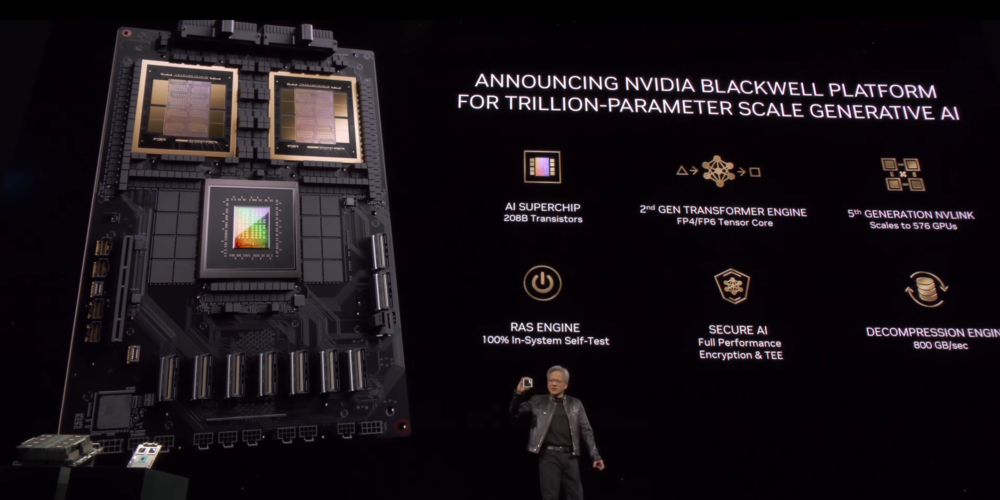

Nouvelles puces – Comme prévu, Nvidia a dévoilé sa prochaine architecture de puces dédiées à l’entraînement des modèles d’IA, un processus qui nécessite une gigantesque puissance de calcul que seule l’informatique dite “accélérée” peut apporter. Baptisée Blackwell, en hommage à un mathématicien américain, celle-ci affiche des performances bien supérieures à l’architecture Hopper, sur laquelle est bâti son GPU H100, la référence actuelle du secteur. La commercialisation d’une première puce, baptisée B200, doit débuter en fin d’année. Une “super puce” couplant deux GPU avec un processeur (CPU) a également été annoncée, tout comme un nouveau “super ordinateur”, contenant 576 GPU et 288 CPU… Comme à son habitude, la société n’a pas communiqué de prix catalogue. Les puces H100 sont vendues entre 25.000 et 40.000 dollars.

Modèles plus gros – Cette nouvelle architecture doit permettre de répondre aux besoins toujours plus élevés de puissance informatique, à mesure que les modèles cherchent à gagner en taille. “Hopper est fantastique mais nous avons besoin de plus gros GPU”, souligne Jensen Huang. Nvidia promet ainsi de pouvoir entraîner des modèles comptant jusqu’à 10.000 milliards de paramètres, là où GPT-4, la dernière version du grand modèle de langage d’OpenAI, n’en totalisait que 1.700 milliards. La société met aussi en avant des gains de temps, tant pour l’entraînement que pour l’inférence (le processus de génération de textes ou d’images). Et d’importantes économies d’énergie. Les grands acteurs du cloud, dont Microsoft, Amazon et Google, seront parmi les premiers à recevoir ces nouveaux produits.

Concurrence – L’objectif de Nvidia est également de conserver une longueur d’avance technologique sur une concurrence qui commence à émerger. En décembre, AMD a lancé son premier accélérateur dédié à l’IA générative – Microsoft et Meta font partie de ses premiers clients. Intel pourrait suivre AMD dès cette année. Microsoft, Google, Amazon et Meta développent aussi des puces d’IA, mais essentiellement pour un usage interne. Et de nouveaux acteurs pourraient émerger, alors que Sam Altman, le patron d’OpenAI, le concepteur de ChatGPT, et Masayoshi Son, à la tête du conglomérat japonais Softbank, cherchent chacun des fonds pour se lancer. En attendant, Nvidia devrait continuer d’enregistrer une croissance spectaculaire. Au quatrième trimestre 2023, son chiffre d’affaires a été multiplié par près de trois. Et ses profits par près de neuf.

Pour aller plus loin:

– L’IA générative propulse Nvidia vers de nouveaux sommets

– ASML lance une machine à 350 millions pour graver les prochaines puces