Ajouter de la colle à la sauce pour éviter que le fromage ne coule de la pizza. Ou encore manger un caillou par jour pour un apport en minéraux et en vitamines. Voilà deux suggestions loufoques faites par… Google. Ou plutôt par la nouvelle fonctionnalité d’intelligence artificielle générative intégrée depuis mi-mai au moteur de recherche – pour le moment, seulement aux États-Unis. Ces réponses ne sont que deux exemples parmi tant d’autres, partagés depuis des jours par les internautes. Certes, ces multiples erreurs ne diffèrent pas vraiment de celles que peuvent écrire d’autres services d’IA, comme ChatGPT. Mais elles pourraient avoir un impact bien plus grand, en raison de la taille de Google, qui capte plus de 90% des recherches en ligne. Avec le risque, pour le moteur, d’une perte de confiance des internautes.

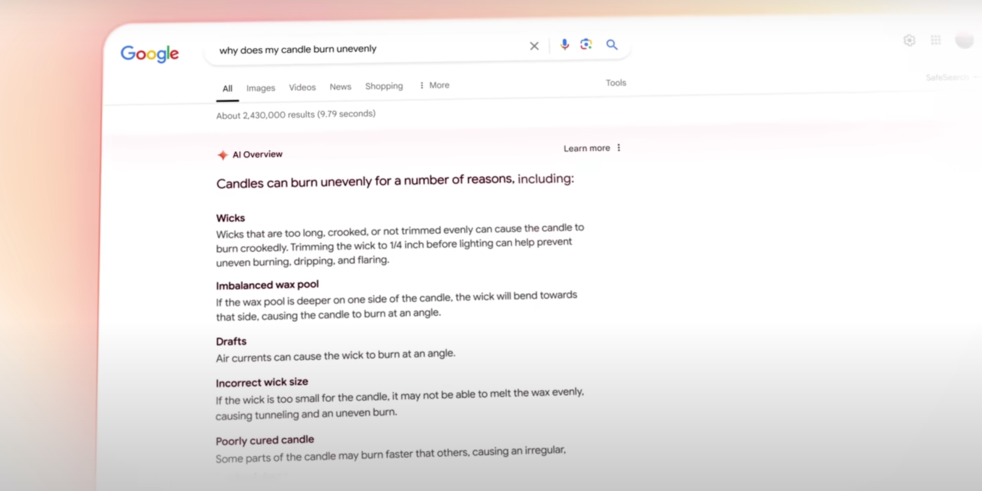

“AI Overview” – Face à ce danger, le géant de Mountain View avait décidé de prendre son temps avant d’ajouter des réponses fournies par l’IA sur sa page de résultats, contrairement à Microsoft. Les rumeurs autour du lancement d’un outil de recherche par OpenAI, le concepteur de ChatGPT, ont certainement accéléré son calendrier. Tout comme le succès de la start-up Perplexity AI. Désormais, Google va afficher, pour certaines recherches, un module baptisé “AI Overview”, au-dessus des traditionnels liens et extraits de site Internet. Celui-ci est alimenté par Gemini, le grand modèle de langage développé en interne. Pour limiter les erreurs et faire remonter des informations pertinentes, le moteur met en avant sa base de données de plus de “1.000 milliards de faits” et son “incomparable système de classement”.

La faute de Reddit ? – Les erreurs des IA génératives, appelées hallucinations, sont inhérentes à leur fonctionnement: les modèles ne font que prédire leur réponse. Des méthodes existent pour les limiter, en particulier la génération augmentée par récupération (RAG), qui permet de se baser uniquement sur une base de connaissance réputée fiable. Sur Google, celle-ci est constituée des pages Internet considérées comme pertinentes – en s’appuyant probablement sur leur popularité. Et des 16 milliards de messages postés sur Reddit, à qui la société va verser près de 200 millions de dollars sur trois ans. Mais l’IA ne sait toujours pas distinguer ce qui est vrai de ce qui est faux. Le conseil sur la pizza provient ainsi d’une blague faite sur Reddit. Celui sur les cailloux d’un article publié par le site parodique The Onion.

Erreurs passées inaperçues – Pour sa défense, Google répond que les erreurs qui circulent ces derniers jours correspondent à “des requêtes peu communes”, qui ne sont pas “représentatives”. Au-delà des réponses loufoques, qui sont clairement identifiables et qui peuvent faire sourire, combien d’erreurs passent inaperçues ? Combien de réponses contiennent des éléments de désinformation ? Une personne qui pose une question ne connaît généralement pas la réponse. Et n’a donc aucun moyen de savoir si les affirmations de Gemini, ou de ChatGPT, sont correctes. Or, Google est réputé comme une source fiable d’information, que les internautes ne remettent pas souvent en doute. La société en a d’ailleurs bien conscience: elle n’affiche pas de réponse générée par l’IA pour les sujets considérés comme sensibles, comme la santé.

Pour aller plus loin:

– Avec l’aide de Microsoft, OpenAI veut concurrencer Google

– Perplexity AI, la start-up qui veut “ringardiser Google”